Nos últimos dois anos, os grandes modelos de linguagem (LLMs) evoluíram de forma extraordinária, muito graças ao acesso a grandes conjuntos de dados e à orientação humana. Ainda assim, costumam enfrentar limites de desempenho à medida que a complexidade e a diversidade das tarefas que executam aumentam. Para resolver essa questão, as pesquisas focam hoje no desenvolvimento dos Self-Evolving Language Models ( LLMs autoevolutivos).

A autoevolução permite que os LLMs adquiram, refinem e aprendam com suas próprias experiências, de forma autônoma, sem supervisão humana. Esse novo paradigma de treinamento — inspirado no aprendizado por tentativa e erro — oferece a possibilidade de dimensionar os LLMs em direção à superinteligência.

A tese é a de que, ao aprender com suas próprias experiências, um LLM pode otimizar seu processo de aprendizagem, reduzindo a necessidade de anotação e supervisão humana extensiva, levando ao treinamento e implantação mais eficientes. E também à escalabilidade e à capacidade de lidar com tarefas sofisticadas.

Portanto, LLMs autoevolutivos podem desenvolver uma compreensão mais profunda da linguagem e do contexto, levando a um desempenho mais robusto em uma ampla gama de tarefas e domínios.

Técnicas para autoevolução

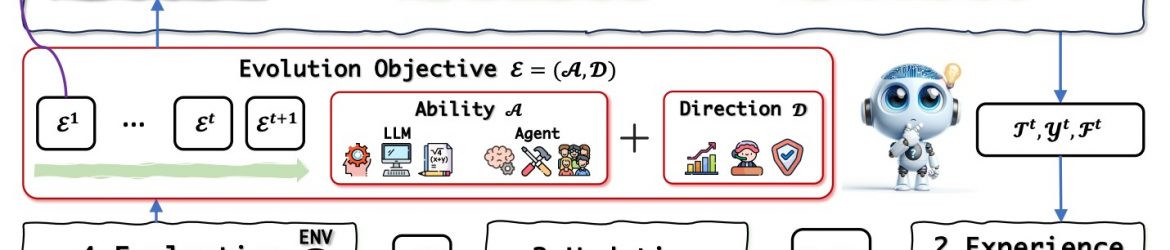

Dias atrás, pesquisadores da Universidade de Pequim, do Grupo Alibaba e da Universidade Tecnológica de Nanyang avançaram algumas casas na autoevolução dos LLMs ao apresentarem um framework abrangente, baseado em um processo cíclico de aquisição, refinamento e atualização de experiência, e avaliação do desempenho do modelo.

O foco é em quatro métodos de aprendizado:

Autoinstrução: O modelo cria suas próprias tarefas, aprende com os resultados e ajusta as respostas com base no feedback, aumentando sua autonomia.

Autojogo: o modelo compete contra si ou simula interações com um ambiente para aprender e refinar estratégias de forma autônoma.

Autoaperfeiçoamento: A autoavaliação contínua permite que o modelo identifique os pontos fracos e otimize os parâmetros, melhorando seu desempenho ao longo do tempo.

Autotreinamento: O modelo gera dados de treinamento de fontes não rotuladas, aproveitando-os para melhorar o desempenho específico da tarefa de forma autônoma.

Além desse framework, outras técnicas inovadoras também estão impulsionando esta tendência. Entre elas:

Imaginação, pesquisa e pensamento crítico: LLMs podem aprimorar seus processos de raciocínio desenvolvendo habilidades de pensamento imaginativo e crítico por meio de técnicas direcionadas.

Autojogo e aprendizagem por reforço: Os pesquisadores projetaram jogos onde os LLMs desempenham diferentes papéis para simular cenários desafiadores. Através da aprendizagem por reforço baseada nos resultados do jogo, os LLMs podem refinar e aprimorar suas habilidades de raciocínio, demonstrando melhorias significativas em várias tarefas de raciocínio.

Otimização de Inferência e Decodificação: O framework LayerSkip permite que LLMs executem inferências computacionalmente mais leves. Introduz saídas antecipadas durante o processo de decodificação, mas mantém a precisão enquanto reduz os requisitos de memória e computacionais.

Raciocínio sobre a execução de código: LLMs treinados para compreender e raciocinar sobre a execução de programas através do método NExT.

Aquisição de meta-habilidades: O médoto SELF (Self-Evolution with Language Feedback) leva o modelo a adquirir meta-habilidades com foco no auto-feedback e no auto-refinamento.

Desafios

Os LLMs autoevolutivos são uma área de pesquisa promissora, mas há obstáculos a superar:

Compreensão teórica: Precisamos de uma compreensão científica mais clara de como os LLMs alcançam a autocorreção e a melhoria.

Qualidade dos dados: O uso de dados autogerados para aprendizagem pode levar a limitações. Encontrar o equilíbrio certo entre dados sintéticos e reais é crucial.

Acompanhamento da mudança: À medida que os LLMs evoluem, os seus mecanismos de autocrítica podem ter dificuldade em acompanhar a evolução das suas capacidades.

Equilíbrio de aprendizagem e estabilidade: Os LLMs precisam de encontrar um equilíbrio entre a retenção do conhecimento existente e a adaptação a novas informações.

Evolução dos benchmarks: Os métodos de avaliação tradicionais podem não ser adequados para LLMs que estão em constante aprendizagem e mudança. São necessários benchmarks dinâmicos para uma avaliação mais precisa.

Segurança e alinhamento: À medida que os LLMs se tornam mais poderosos, é fundamental garantir que eles se alinhem com os valores humanos e a ética. Técnicas como testes de resistência e interpretabilidade são cruciais para o desenvolvimento seguro e responsável da IA.

À medida que esses modelos ganham autonomia, seu alinhamento contínuo com os objetivos e valores humanos se tornará crucial. Nesse sentido, é notável que os LLMs também estejam começando a desenvolver seus próprios sistemas de valores. Por exemplo: o framework ValueLex, criado por pesquisadores da Universidade de Tsinghua e da Microsoft Research Asia, descobriu sistemas de valores com dimensões como competência, caráter e integridade.

Essa nova linha de pesquisa é fundamental para entender como o design do modelo influencia o desenvolvimento de valores e, em última análise, orienta as considerações éticas no desenvolvimento da IA.

A pesquisa contínua, a colaboração interdisciplinar e a avaliação rigorosa serão essenciais para liberar todo o potencial dos LLMs autoevolutivos e garantir sua integração segura e benéfica em nosso mundo.

FONTE: THE SHIFT