Startup do Reino Unido diz que montou um banco de dados com 300 milhões de imagens de rostos para a avaliação

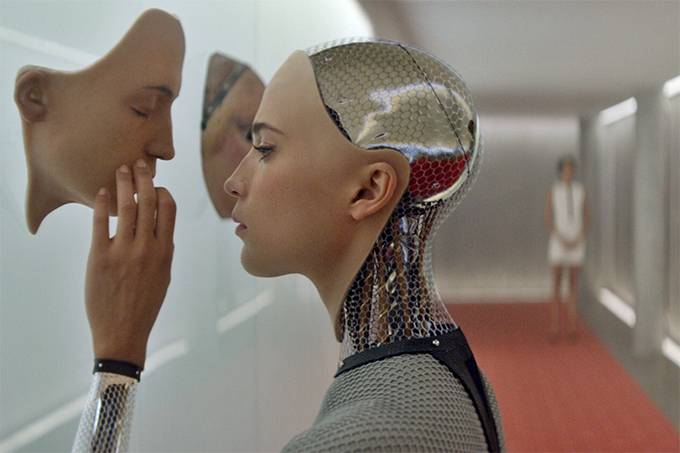

Inteligência artificial: startup tem solução de software para avaliar mentiras (Ex Machina/Reprodução)

Cerca de quatro décadas atrás, a pesquisa do psicólogo americano Paul Ekman sobre expressões faciais deu origem a uma nova carreira de detectores de mentiras humanos. Agora, o emprego desses profissionais pode estar ameaçado pela inteligência artificial.

Embora os Estados Unidos tenham sido pioneiros no uso de tecnologias automatizadas para revelar emoções e reações ocultas dos suspeitos, a técnica ainda é incipiente e várias empresas tentam torná-la mais eficiente e menos propensa a erros.

A Facesoft, uma startup do Reino Unido, diz que montou um banco de dados com 300 milhões de imagens de rostos, alguns dos quais foram criados por um sistema de inteligência artificial com base no cérebro humano, informou o The Times.

O sistema desenvolvido pela empresa pode identificar emoções como raiva, medo e surpresa, com base em microexpressões, muitas vezes invisíveis ao observador comum.

“Se alguém sorri sem sinceridade, a boca pode sorrir, mas o sorriso não chega aos olhos – as microexpressões são mais sutis e mais rápidas”, diz o cofundador e presidente da Facesoft, Allan Ponniah, que também é cirurgião plástico e reconstrutor em Londres, disse o jornal.

A Facesoft entrou em contato com a polícia em Mumbai para o uso do sistema no monitoramento de multidões, disse Ponniah. Também divulgou seu produto para as forças policiais do Reino Unido.

O uso de algoritmos de inteligência artificial entre policiais provocou polêmica recentemente. Um grupo de pesquisa cujos membros incluem Facebook, Microsoft, Alphabet, que controla o Google, Amazon.com e Apple publicou um relatório em abril afirmando que os algoritmos atuais que visam ajudar a polícia a determinar quem deve receber fiança, liberdade condicional ou liberdade vigiada e que ajudam os juízes a tomar decisões são potencialmente parciais, opacos e podem nem funcionar.

O grupo, chamado Partnership on AI, descobriu que esses sistemas já são amplamente usados nos EUA e ganham espaço em outros países.

FONTE: EXAME